参考

简介

- log for java 一个Java的日志框架

hello world

配置依赖

- log4j-api-2.5.jar

- log4j-core-2.5.jar

- 下载地址

运行

1 | import org.apache.logging.log4j.LogManager; |

ERROR StatusLogger No Log4j 2 configuration file found. Using default configuration (logging only errors to the console), or user programmatically provided configurations. Set system property ‘log4j2.debug’ to show Log4j 2 internal initialization logging. See https://logging.apache.org/log4j/2.x/manual/configuration.html for instructions on how to configure Log4j 2

20:49:25.138 [main] ERROR - error level

20:49:25.142 [main] FATAL - fatal level

- 第一行是提示没有找到配置文件,需要在classpath目录下创建log4j.json、log4j.jsn、log4j2.xml等名称的文件

配置文件

创建一个log4j2.xml1

2

3

4

5

6

7

8

9

10

11

12

13

14

<Configuration status="WARN">

<Appenders>

<Console name="Console" target="SYSTEM_OUT">

<PatternLayout pattern="%d{HH:mm:ss.SSS} [%t] %-5level %logger{36} - %msg%n" />

</Console>

</Appenders>

<Loggers>

<Root level="error">

<AppenderRef ref="Console" />

</Root>

</Loggers>

</Configuration>

- 重新运行代码,不会提示警告信息

- 来看我们添加的配置文件log4j2.xml,以Configuration为根节点,有一个status属性,这个属性表示log4j2本身的日志信息打印级别。如果把status改为TRACE再执行测试代码,可以看到控制台中打印了一些log4j加载插件、组装logger等调试信息。

日志简介

日志级别从低到高分为TRACE < DEBUG < INFO < WARN < ERROR < FATAL,如果设置为WARN,则低于WARN的信息都不会输出。对于Loggers中level的定义同样适用。

详解配置文件

Configuration

1 | <Configuration status="WARN" monitorInterval="300"> |

- 有一个status属性,这个属性表示log4j2本身的日志信息打印级别。如果把status改为TRACE再执行测试代码,可以看到控制台中打印了一些log4j加载插件、组装logger等调试信息。

- monitorInterval属性,含义是每隔300秒重新读取配置文件,可以不重启应用的情况下修改配置,还是很好用的功能。

### Appenders1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17<Configuration status="error">

<Appenders>

<Console name="Console" target="SYSTEM_OUT">

<PatternLayout

pattern="%d{HH:mm:ss.SSS} [%t] %-5level %logger{36} - %msg%n" />

</Console>

<File name="MyFile" fileName="D:/logs/app.log">

<PatternLayout pattern="%d{HH:mm:ss.SSS} [%t] %-5level %logger{36} - %msg%n" />

</File>

</Appenders>

<Loggers>

<Root level="error">

<AppenderRef ref="Console" />

<AppenderRef ref="MyFile" />

</Root>

</Loggers>

</Configuration>

- 包含了多个Appender

- 其中root的log输出到两个地方,第一个是控制台,第二个是输出到文件,同时都输出

- Appender可以理解为日志的输出目的地,这里配置了一个类型为Console的Appender,也就是输出到控制台。Console节点中的PatternLayout定义了输出日志时的格式:

| 格式 | 含义 |

|---|---|

| %d{HH:mm:ss.SSS} | 表示输出到毫秒的时间 |

| %t | 输出当前线程名称 |

| %-5level | 输出日志级别,-5表示左对齐并且固定输出5个字符,如果不足在右边补0 |

| %logger | 输出logger名称,因为Root Logger没有名称,所以没有输出 |

| %msg | 日志文本 |

| %n | 换行 |

| %F | 输出所在的类文件名,如Client.java |

| %L | 输出行号 |

| %M | 输出所在方法名 |

| %l | 输出语句所在的行数, 包括类名、方法名、文件名、行数 |

Loggers

1 | <Configuration status="error"> |

1 | Logger logger = LogManager.getLogger("mylog"); |

- 增加了一个mylog的logger,他的等级是debug,输出大于等于debug的日志信息

- additivity=”false”表示在该logger中输出的日志不会再延伸到父层logger。这里如果改为true,会用root logger指定的方式输出

例如一个logger的level是trace,root的level是error,如果additivity=”true”他会同时使用root指定的方式和logger指定的方式输出全部日志,也就是说level是用的logger的,输出方式用的root和logger都有

实用型配置

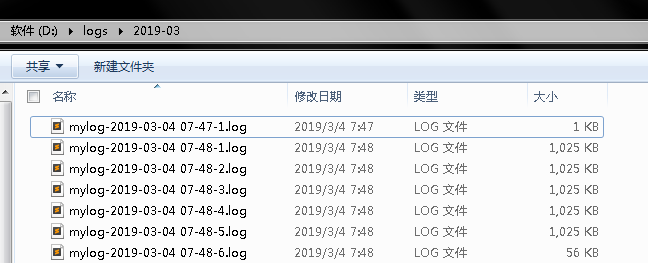

配置一个按时间和文件大小滚动的RollingRandomAccessFile Appender,名字真是够长,但不光只是名字长,相比RollingFileAppender有很大的性能提升,官网宣称是20-200%。

Rolling的意思是当满足一定条件后,就重命名原日志文件用于备份,并从新生成一个新的日志文件。例如需求是每天生成一个日志文件,但是如果一天内的日志文件体积已经超过1G,就从新生成,两个条件满足一个即可。这在log4j 1.x原生功能中无法实现,在log4j2中就很简单了。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29<Configuration status="error">

<properties>

<property name="LOG_HOME">D:/logs</property>

<property name="FILE_NAME">mylog</property>

</properties>

<Appenders>

<Console name="Console" target="SYSTEM_OUT">

<PatternLayout

pattern="%d{HH:mm:ss.SSS} [%t] %-5level %logger{36} - %msg%n" />

</Console>

<RollingRandomAccessFile name="MyFile"

fileName="${LOG_HOME}/${FILE_NAME}.log"

filePattern="${LOG_HOME}/$${date:yyyy-MM}/${FILE_NAME}-%d{yyyy-MM-dd HH-mm}-%i.log">

<PatternLayout

pattern="%d{yyyy-MM-dd HH:mm:ss.SSS} [%t] %-5level %logger{36} - %msg%n" />

<Policies>

<TimeBasedTriggeringPolicy interval="1" />

<SizeBasedTriggeringPolicy size="1 MB" />

</Policies>

<DefaultRolloverStrategy max="20" />

</RollingRandomAccessFile>

</Appenders>

<Loggers>

<Root level="error">

<AppenderRef ref="Console" />

<AppenderRef ref="MyFile" />

</Root>

</Loggers>

</Configuration>

定义了两个常量方便后面复用 - RollingRandomAccessFile的属性:

- fileName 指定当前日志文件的位置和文件名称

- filePattern 指定当发生Rolling时,文件的转移和重命名规则

- SizeBasedTriggeringPolicy 指定当文件体积大于size指定的值时,触发Rolling

- DefaultRolloverStrategy 指定最多保存的文件个数

- TimeBasedTriggeringPolicy 这个配置需要和filePattern结合使用,注意filePattern中配置的文件重命名规则是${FILE_NAME}-%d{yyyy-MM-dd HH-mm}-%i,最小的时间粒度是mm,即分钟,TimeBasedTriggeringPolicy指定的size是1,结合起来就是每1分钟生成一个新文件。如果改成%d{yyyy-MM-dd HH},最小粒度为小时,则每一个小时生成一个文件。%i表示第几个文件

自定义配置文件路径

log4j2默认在classpath下查找配置文件,可以修改配置文件的位置。在非web项目中:1

2

3

4

5

6File file = new File("D:/log4j2.xml");

BufferedInputStream in = new BufferedInputStream(new FileInputStream(file));

final ConfigurationSource source = new ConfigurationSource(in);

Configurator.initialize(null, source);

Logger logger = LogManager.getLogger("mylog");

如果是web项目,在web.xml中添加1

2

3

4

5

6

7

8<context-param>

<param-name>log4jConfiguration</param-name>

<param-value>/WEB-INF/conf/log4j2.xml</param-value>

</context-param>

<listener>

<listener-class>org.apache.logging.log4j.web.Log4jServletContextListener</listener-class>

</listener>

按日志级别区分文件输出

有些人习惯按日志信息级别输出到不同名称的文件中,如info.log,error.log,warn.log等,在log4j2中可通过配置Filters来实现。

假定需求是把INFO及以下级别的信息输出到info.log,WARN和ERROR级别的信息输出到error.log,FATAL级别输出到fatal.log,配置文件如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63<Configuration status="WARN" monitorInterval="300">

<properties>

<property name="LOG_HOME">D:/logs</property>

</properties>

<Appenders>

<Console name="Console" target="SYSTEM_OUT">

<PatternLayout pattern="%d{HH:mm:ss.SSS} [%t] %-5level %logger{36} - %msg%n" />

</Console>

<RollingRandomAccessFile name="InfoFile"

fileName="${LOG_HOME}/info.log"

filePattern="${LOG_HOME}/$${date:yyyy-MM}/info-%d{yyyy-MM-dd}-%i.log">

<Filters>

<ThresholdFilter level="warn" onMatch="DENY" onMismatch="NEUTRAL" />

<ThresholdFilter level="trace" onMatch="ACCEPT" onMismatch="DENY" />

</Filters>

<PatternLayout pattern="%date{yyyy-MM-dd HH:mm:ss.SSS} %level [%thread][%file:%line] - %msg%n" />

<Policies>

<TimeBasedTriggeringPolicy />

<SizeBasedTriggeringPolicy size="10 MB" />

</Policies>

<DefaultRolloverStrategy max="20" />

</RollingRandomAccessFile>

<RollingRandomAccessFile name="ErrorFile"

fileName="${LOG_HOME}/error.log"

filePattern="${LOG_HOME}/$${date:yyyy-MM}/error-%d{yyyy-MM-dd}-%i.log">

<Filters>

<ThresholdFilter level="fatal" onMatch="DENY" onMismatch="NEUTRAL" />

<ThresholdFilter level="warn" onMatch="ACCEPT" onMismatch="DENY" />

</Filters>

<PatternLayout pattern="%date{yyyy-MM-dd HH:mm:ss.SSS} %level [%thread][%file:%line] - %msg%n" />

<Policies>

<TimeBasedTriggeringPolicy />

<SizeBasedTriggeringPolicy size="10 MB" />

</Policies>

<DefaultRolloverStrategy max="20" />

</RollingRandomAccessFile>

<RollingRandomAccessFile name="FatalFile"

fileName="${LOG_HOME}/fatal.log"

filePattern="${LOG_HOME}/$${date:yyyy-MM}/fatal-%d{yyyy-MM-dd}-%i.log">

<Filters>

<ThresholdFilter level="fatal" onMatch="ACCEPT" onMismatch="DENY" />

</Filters>

<PatternLayout pattern="%date{yyyy-MM-dd HH:mm:ss.SSS} %level [%thread][%file:%line] - %msg%n" />

<Policies>

<TimeBasedTriggeringPolicy />

<SizeBasedTriggeringPolicy size="10 MB" />

</Policies>

<DefaultRolloverStrategy max="20" />

</RollingRandomAccessFile>

</Appenders>

<Loggers>

<Root level="trace">

<AppenderRef ref="Console" />

<AppenderRef ref="InfoFile" />

<AppenderRef ref="ErrorFile" />

<AppenderRef ref="FatalFile" />

</Root>

</Loggers>

</Configuration>

测试代码:1

2

3

4

5

6

7

8

9public static void main(String[] args) {

Logger logger = LogManager.getLogger(Client.class);

logger.trace("trace level");

logger.debug("debug level");

logger.info("info level");

logger.warn("warn level");

logger.error("error level");

logger.fatal("fatal level");

}

异步写日志

1 | <Configuration status="WARN" monitorInterval="300"> |

测试代码:1

2

3

4

5

6

7

8

9public static void main(String[] args) {

Logger logger = LogManager.getLogger("asynclog");

logger.trace("trace level");

logger.debug("debug level");

logger.info("info level");

logger.warn("warn level");

logger.error("error level");

logger.fatal("fatal level");

}

输出到MongoDB

添加依赖:1

2

3

4

5

6

7

8

9

10<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-nosql</artifactId>

<version>2.5</version>

</dependency>

<dependency>

<groupId>org.mongodb</groupId>

<artifactId>mongo-java-driver</artifactId>

<version>3.2.2</version>

</dependency>

配置文件:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21<Configuration status="WARN" monitorInterval="300">

<Appenders>

<Console name="Console" target="SYSTEM_OUT">

<PatternLayout pattern="%d{HH:mm:ss.SSS} [%t] %-5level %logger{36} - %msg%n" />

</Console>

<NoSql name="databaseAppender">

<MongoDb databaseName="test" collectionName="errorlog"

server="localhost" port="27017" />

</NoSql>

</Appenders>

<Loggers>

<Logger name="mongolog" level="trace" additivity="false">

<AppenderRef ref="databaseAppender" />

</Logger>

<Root level="error">

<AppenderRef ref="Console" />

</Root>

</Loggers>

</Configuration>

输出到Flume

Flume配置(flume-conf.properties)1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20agent1.sources=source1

agent1.sinks=sink1

agent1.channels=channel1

agent1.sources.source1.type=avro

agent1.sources.source1.channels=channel1

agent1.sources.source1.bind=0.0.0.0

agent1.sources.source1.port=41414

agent1.sinks.sink1.type=file_roll

agent1.sinks.sink1.sink.directory=D:/log

agent1.sinks.sink1.channel=channel1

agent1.sinks.sink1.sink.rollInterval=86400

agent1.sinks.sink1.sink.batchSize=100

agent1.sinks.sink1.sink.serializer=text

agent1.sinks.sink1.sink.serializer.appendNewline = false

agent1.channels.channel1.type=file

agent1.channels.channel1.checkpointDir=D:/log/checkpoint

agent1.channels.channel1.dataDirs=D:/log/data

启动Flume(注:测试环境为windows)1

flume-ng.cmd agent --conf ../conf/ --conf-file ../conf/flume-conf.properties -name agent1

添加依赖:1

2

3

4

5<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-flume-ng</artifactId>

<version>2.5</version>

</dependency>

配置文件:1

2

3

4

5

6

7

8

9

10

11

12

13<Configuration status="WARN" monitorInterval="300">

<Appenders>

<Flume name="eventLogger" compress="false">

<Agent host="127.0.0.1" port="41414" />

<RFC5424Layout enterpriseNumber="18060" includeMDC="true" appName="MyApp" />

</Flume>

</Appenders>

<Loggers>

<Root level="trace">

<AppenderRef ref="eventLogger" />

</Root>

</Loggers>

</Configuration>